Für die Zeitschrift „journalist“ des Deutschen Journalisten Verbandes DJV hatte ich in der Ausgabe 06/12 einen Ratgeber zum Thema Datenjournalismus bei Lokalzeitungen geschrieben. Der Text erschien heute online:

Für die Zeitschrift „journalist“ des Deutschen Journalisten Verbandes DJV hatte ich in der Ausgabe 06/12 einen Ratgeber zum Thema Datenjournalismus bei Lokalzeitungen geschrieben. Der Text erschien heute online:

Alles auf eine Karte

Haushaltszahlen, Kriminalitätsstatistiken, Sportergebnisse, Wetterberichte, Verkehrsaufkommen: Gerade lokale und regionale Medien können von den enormen Datenmengen, die es heute gibt, profitieren. Datenjournalist Lorenz Matzat hat für den journalist aufgeschrieben, wie aus einer Lokalzeitungsredaktion ein Datenjournalismus-Labor werden kann.

Rick Perry hatte Großes vor. Der Gouverneur von Texas wollte neuer US-Präsident werden. Doch im Januar gab er auf. Am mangelnden Einsatz im Bundesstaat Iowa kann das nicht gelegen haben. Mehr als 100 Wahlkampfauftritte absolvierte Perry landauf landab. Die Onlinezeitung Texas Tribune dokumentierte seine Kampagne mit einem einfachen Mittel. Auf einer interaktiven Karte markierte sie sämtliche Auftritte und Termine des Kandidaten. Jede Markierung verwies auf weiterführende Artikel. Die Resonanz war groß. Warum sollte nicht auch mal eine Zeitung in Nordrhein-Westfalen auf die Idee kommen, etwa den Wahlkampf des FDP-Spitzenkandidaten Christian Lindner auf diese Weise im Web zu begleiten?

Gerade für Lokalzeitungen ist es lohnenswert, sich mit Datenjournalismus zu beschäftigen. Wichtigste Voraussetzung ist schlicht ein Bewusstsein für die Möglichkeiten, die in jenen Daten stecken, die ohnehin täglich in den Redaktionen auflaufen. Dass Leser sich dafür interessieren, zeigen Vorreiter wie der britische Guardian und die Texas Tribune. In Reading the Riots widmete sich etwa der Guardian ausführlich den sozio-demografischen Hintergründen, die 2011 zu den Krawallen in England beigetragen haben dürften. Heraus kam ein Textdossier, das mit Infografiken und interaktiven Datenvisualisierungen angereichert war.

Der Data Desk der LA Times zeigt, wie sich die unterschiedlichen Bereiche lokal aufgreifen lassen. Dabei ist Datenjournalismus noch ein junges Genre. Es lässt sich darüber streiten, ob es nun etwas eigenständig Neues ist oder nur ein neuer Begriff für die althergebrachte computergestützte Recherche. In Europa machte der sogenannte data driven journalism erstmals von sich reden, als der Guardian Anfang 2009 sein Datablog gründete.

Zwar dürften die meisten lokalen Medienhäuser anders als große Verlage nicht in der Lage sein, eigene Datenredaktionen mit Rechercheuren, Programmierern und Designern aufzubauen. Doch die lokale Berichterstattung hat einen großen Vorteil: Sie kann sich auf ein klar umrissenes geografisches Gebiet konzentrieren. Auf Karten sichtbar gemacht, können Geodaten so auf einen Blick lokale Informationen abbilden.

Versucht man, sich dem Datenjournalismus als Genre zu nähern, lassen sich drei Ebenen unterscheiden: erstens die Verlagsebene, zweitens der Workflow in der Redaktion und drittens die Arbeitsweise der einzelnen Journalisten. Der Reihe nach …

Weiterlesen bei journalist.de

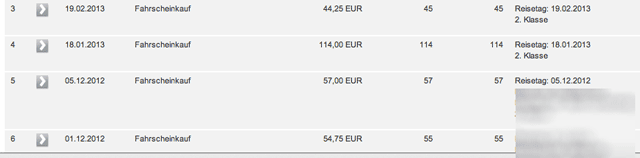

Vergangenen Sonntag sorgte eine Vorabmeldung von Spiegel Online für einige Aufmerksamkeit: Sie wies auf einen Artikel im neuen Print-Spiegel hin und behauptete gewohnt reißerisch, die Bahn wolle Kundendaten verkaufen (die Bahn dementierte). De facto, so sezierte es dann Malte Spitz, der sich sowohl den Print-Spiegelartikel angesehen hatte als auch das Kleingedruckte bei der Bahn, hatte SpOn den Text nicht richtig wiedergegeben. Es ging vielmehr darum, dass die Bahn bestimmte AGB geändert hat, um konzernintern die BahnBonus-Daten weitergeben zu können; also das Reiseverhalten derjenigen, die an dem Bonusprogramm teilnehmen, effektiver auswerten zu können, um die jeweiligen Kunden passgenauer mit Werbung zu beschicken (Targeting).

Vergangenen Sonntag sorgte eine Vorabmeldung von Spiegel Online für einige Aufmerksamkeit: Sie wies auf einen Artikel im neuen Print-Spiegel hin und behauptete gewohnt reißerisch, die Bahn wolle Kundendaten verkaufen (die Bahn dementierte). De facto, so sezierte es dann Malte Spitz, der sich sowohl den Print-Spiegelartikel angesehen hatte als auch das Kleingedruckte bei der Bahn, hatte SpOn den Text nicht richtig wiedergegeben. Es ging vielmehr darum, dass die Bahn bestimmte AGB geändert hat, um konzernintern die BahnBonus-Daten weitergeben zu können; also das Reiseverhalten derjenigen, die an dem Bonusprogramm teilnehmen, effektiver auswerten zu können, um die jeweiligen Kunden passgenauer mit Werbung zu beschicken (Targeting). Für die Zeitschrift „journalist“ des Deutschen Journalisten Verbandes DJV hatte ich in der Ausgabe 06/12 einen Ratgeber zum Thema Datenjournalismus bei Lokalzeitungen geschrieben. Der Text erschien heute online:

Für die Zeitschrift „journalist“ des Deutschen Journalisten Verbandes DJV hatte ich in der Ausgabe 06/12 einen Ratgeber zum Thema Datenjournalismus bei Lokalzeitungen geschrieben. Der Text erschien heute online: